Опубликовано dmakarova в Втр, 08/26/2025 - 12:39

В последние годы масштаб и частота кибератак достигли беспрецедентного уровня. Взломы, использующие уязвимости в программном обеспечении, наносят ущерб не только отдельным компаниям, но и целым отраслям.

Подобные инциденты показали: даже одно уязвимое звено в цепочке поставки программного обеспечения может привести к катастрофическим последствиям. В условиях такой киберугрозы организациям становится жизненно важно использовать только надежное, проверенное и защищённое ПО. Недостаточно полагаться на внешние меры защиты — безопасность должна быть встроена в продукт с самого начала.

Именно поэтому внимание к информационной безопасности при разработке, закупке и сопровождении программных решений сегодня стало стратегической необходимостью. В этой статье мы рассмотрим ключевые подходы к безопасной разработке программного обеспечения и расскажем, как они реализованы на практике в платформе IT-мониторинга wiSLA.

Что такое разработка безопасного программного обеспечения?

Разработка безопасного программного обеспечения — это методология (часто связанная с практиками DevSecOps), при которой безопасность интегрируется на каждом этапе жизненного цикла разработки ПО (SDLC). Безопасность «вшивается» в код с самого начала, а не рассматривается постфактум, когда тестирование выявляет критические уязвимости. Иными словами, безопасность становится частью процесса планирования еще до написания первой строки кода.

Традиционно безопасность воспринимается разработчиками как препятствие для инноваций и творчества, способное замедлить вывод продукта на рынок. Однако такой подход наносит прямой ущерб бизнесу: исправление ошибки на этапе реализации обходится в 6 раз дороже, чем на этапе проектирования, а в фазе тестирования — в 15 раз дороже.

Но, в конечном счете, насколько будут довольны клиенты даже самыми «крутыми» функциями приложения, если в нем полно уязвимостей, которыми могут воспользоваться злоумышленники? Сегодня безопасность должна занимать ключевое место в инженерном процессе, и только те организации, которые это понимают, смогут оставаться конкурентоспособными.

Как же включить безопасность в SDLC с самого начала?

Во-первых, проводить тестирование как можно раньше и как можно чаще. Подход к безопасной разработке предполагает использование как статического, так и динамического тестирования безопасности на всех этапах разработки. Во-вторых, команды разработки должны документировать требования к безопасности наряду с функциональными требованиями. И наконец, проведение анализа рисков на этапе проектирования помогает заранее выявить возможные угрозы со стороны внешней среды или инфраструктуры.

Компании, стремящиеся создавать по-настоящему безопасное программное обеспечение, должны закладывать прочный фундамент — готовить к этой задаче своих людей, процессы и технологии. Эффективная подготовка начинается с разработки четкой политики безопасной разработки — документа, без которого невозможна системная работа в этом направлении.

Подходы к обеспечению безопасности ПО

Статический анализ кода программного обеспечения: выявление уязвимостей на раннем этапе

Статический анализ (SAST, Static Application Security Testing) — это один из ключевых методов обеспечения безопасности на этапе разработки программного обеспечения. Его суть заключается в автоматическом или ручном изучении исходного кода без его выполнения. Такой подход позволяет обнаруживать уязвимости и ошибки еще до запуска приложения, то есть задолго до того, как они могут быть использованы злоумышленниками в реальной атаке.

В процессе статического анализа проверяется синтаксис, структура кода, логика обработки данных, соответствие лучшим практикам безопасного программирования. Особое внимание уделяется потенциально опасным участкам, таким как обработка пользовательского ввода, работа с памятью, межмодульные вызовы и доступ к системным ресурсам. Типичные уязвимости, обнаруживаемые на этом этапе, включают некорректную обработку исключений, использование устаревших или небезопасных конструкций, утечки памяти, уязвимости типа buffer overflow, SQL-инъекции и другие.

Одним из главных преимуществ статического анализа является возможность его интеграции в процесс непрерывной разработки (CI/CD). Он может выполняться автоматически при каждом коммите в репозиторий, тем самым предотвращая попадание уязвимостей в основную ветку проекта. Такой подход соответствует принципу shift-left в DevSecOps — выявление проблем безопасности как можно раньше.

Российские решения для статического анализа кода:

-

МаксПатрол (MaxPatrol SAST) — коммерческий продукт от Positive Technologies, предназначенный для глубокого анализа исходного кода и выявления уязвимостей в соответствии с российскими и международными стандартами безопасности;

-

КриптоПро Код Анализ — специализированный инструмент, ориентированный на обеспечение соответствия криптографическим требованиям и стандартам ГОСТ, широко используется в государственных и банковских проектах;

-

РЭПЕР (REPER) — система анализа уязвимостей и ошибок в коде с акцентом на соответствие требованиям информационной безопасности в защищенных системах;

-

ToolKit — набор инструментов для комплексного анализа приложений, включая выявление логических ошибок, проверку архитектурных решений и оценку рисков;

-

Cynet — интегрированное решение в сфере кибербезопасности, включающее модули для анализа кода и предотвращения угроз на разных уровнях;

-

SAST от Positive Technologies — ещё один представитель отечественной линейки решений, ориентированный на интеграцию в DevSecOps‑процессы крупных корпоративных заказчиков.

Зарубежные решения для статического анализа кода:

-

SonarQube — один из самых популярных анализаторов, доступен как в бесплатной, так и в платной версиях. Поддерживает множество языков, имеет собственную систему оценки рисков, интегрируется с CI/CD и позволяет настраивать собственные правила проверки;

-

Checkmarx — мощное решение корпоративного уровня, предоставляющее детализированные отчёты по найденным уязвимостям, оценку уровня риска и рекомендации по устранению;

-

Fortify Static Code Analyzer — решение от Micro Focus, ориентированное на безопасность крупных систем. Поддерживает широкий спектр языков программирования, интеграцию с IDE и CI/CD;

-

ESLint — бесплатный инструмент, в первую очередь предназначенный для контроля качества и безопасности JavaScript-кода. Также поддерживает TypeScript и может быть адаптирован под Python.

Open source решения для статического анализа кода:

-

Bandit — удобный инструмент для анализа Python-кода, фокусируется на безопасности и помогает выявлять распространенные уязвимости;

-

Pylint — инструмент проверки качества Python-кода, также может быть использован для поиска потенциальных проблем и нарушений безопасности;

-

SonarQube API — позволяет автоматизировать процесс сканирования кода, интегрировать отчёты в собственные панели мониторинга и гибко адаптировать под нужды команды.

Важно понимать, что выбор инструмента зависит от множества факторов: используемого языка программирования, специфики проекта, уровня требований к безопасности и бюджета. Некоторые проекты могут использовать сразу несколько анализаторов, дополняя их работу.

Фаззинг: выявление скрытых уязвимостей через хаос

Фаззинг (fuzz testing) — это метод динамического тестирования безопасности, заключающийся в автоматизированной генерации и передаче в программу случайных, некорректных или преднамеренно искаженных входных данных. Цель — спровоцировать неожиданные сбои, ошибки выполнения, утечки памяти, зависания или другие проявления нестабильного поведения, которые могут свидетельствовать о наличии уязвимостей. Этот подход особенно эффективен в обнаружении так называемых «скрытых» багов, которые сложно выявить другими способами, в том числе при ручном или статическом анализе.

Принцип фаззинга строится на следующем: чем больше неожиданностей получает система, тем выше шанс, что она проявит нестабильность в условиях, приближенных к реальным атакам. Это делает фаззинг мощным инструментом для тестирования компонентов, обрабатывающих внешние данные: API-интерфейсов, парсеров, сетевых модулей, систем сериализации и других участков, уязвимых к атаке типа «input injection».

Фаззинг применяется не только для приложений, но и для библиотек, протоколов, файловых обработчиков и любых компонентов, принимающих входные данные. Он активно используется как в продуктах с открытым исходным кодом, так и в коммерческой разработке, и особенно востребован в проектах, где безопасность критична: от веб-приложений до встраиваемого ПО.

Преимущества фаззинга:

-

автоматическое покрытие широкого спектра сценариев;

-

обнаружение нестабильных состояний, утечек памяти и race conditions;

-

высокая эффективность при минимальном вмешательстве со стороны человека;

-

может использоваться как в ранней разработке, так и на этапе приемочного тестирования.

Недостатки и ограничения:

-

не гарантирует полного покрытия кода или всех уязвимостей;

-

требует настройки окружения для корректной фиксации сбоев (например, интеграции с отладчиком, логированием или краш-репортами);

-

при плохом инструменте или сценарии может генерировать большое количество «мусорных» данных.

Популярные инструменты фаззинга:

jMeter — бесплатный инструмент фаззинга, предназначенный для Java и некоторых других языков. Прост в использовании и хорошо подходит для начального внедрения фаззинг-практик в команду.

Atheris — инструмент фаззинга от Google, разработанный специально для Python 3.8+. Atheris позволяет создавать точные фаззинг-тесты, используя генераторы структурированных данных, что значительно повышает качество покрытия и снижает шум от ложных срабатываний. Он интегрируется с AddressSanitizer и другими анализаторами, работает с C-подмодулями и поддерживает fuzz-тестирование API.

AFL (American Fuzzy Lop) — один из самых известных инструментов фаззинга, ориентирован на нативные бинарные приложения. Позволяет генерировать полезные входные данные с минимальной ручной настройкой благодаря встроенной системе сбора покрытия кода.

libFuzzer — встроенный в LLVM инструмент фаззинга, особенно популярен в разработке на C/C++. Позволяет создавать точечные, контролируемые fuzz-тесты с глубокой интеграцией в проект.

Fuzzilli — фаззер для JavaScript-движков, использующий генерацию валидного, но неожиданного JS-кода, направленного на вызов ошибок исполнения и крашей.

Динамический анализ кода: проверка безопасности в действии

Динамический анализ кода (DAST, Dynamic Application Security Testing) — это методика тестирования, при которой программа исполняется в реальном времени, а ее поведение отслеживается с целью выявления уязвимостей, недочетов логики или нестабильной работы. В отличие от статического анализа, здесь речь идет не о структуре кода, а о его фактическом поведении в условиях, приближенных к реальной эксплуатации.

Метод особенно эффективен для обнаружения таких проблем, которые проявляются только во время выполнения: утечек памяти, некорректной работы с указателями, гонок данных (race conditions), ошибок обращения к файловой системе или базам данных, некорректной обработки пользовательского ввода, нарушений прав доступа и логики авторизации.

Динамический анализ полезен как для десктопных, так и для серверных и web-приложений, в том числе, построенных на микросервисной архитектуре. Его можно использовать на этапе интеграционного и системного тестирования, а также в ходе приемочного контроля перед выпуском обновлений.

Инструменты и подходы к динамическому анализу:

PySnooper — простой, но полезный инструмент для Python-разработчиков. Он позволяет отслеживать выполнение кода построчно, помогая выявить неожиданные значения переменных и логические отклонения в поведении функций. Подходит для начальной отладки и анализа сложных условий.

Valgrind — мощный инструмент анализа памяти, особенно эффективен при работе с программами на C/C++ и других низкоуровневых языках. Valgrind позволяет выявлять утечки памяти, ошибки доступа к памяти, использование неинициализированных переменных и другие типичные проблемы, способные привести к критическим уязвимостям. Существуют методы интеграции с Python и другими языками через обёртки или интерпретаторы.

Burp Suite (Pro/Community) — одно из самых популярных решений для анализа веб-приложений. Поддерживает перехват и модификацию HTTP-запросов, автоматическое сканирование на OWASP-уязвимости, проверку безопасности API, модуль фаззинга и тестирование авторизации. В версии Pro доступны продвинутые функции, включая автоматическое построение карты сайта и активные проверки безопасности.

Kali Linux — дистрибутив Linux, специально предназначенный для тестирования безопасности, содержит сотни предустановленных инструментов для анализа приложений, сетей, протоколов и баз данных. В его составе доступны утилиты для CVE-сканирования, сетевого анализа, фаззинга, тестирования API и многого другого. В частности, можно использовать такие утилиты, как Nikto, wpscan, sqlmap и другие в рамках динамического анализа.

Сканеры уязвимостей библиотек и окружения — например, Snyk, NVD (National Vulnerability Database), GitHub Advisory Database. Эти инструменты позволяют проверять как основное приложение, так и подключенные зависимости (включая пакеты, используемые через pip, npm, Maven и т.д.) на предмет известных уязвимостей. В случае динамической интеграции они могут отслеживать используемые версии библиотек в рантайме.

Библиотеки и фреймворки анализа сетевого трафика и выполнения кода — в том числе open source-решения, которые позволяют встроенно отслеживать выполнение участков кода или анализировать поведение программ, обрабатывающих сетевые запросы (например, libpcap, Scapy, strace и др.).

Многие из инструментов динамического анализа также применяются в рамках пентестинга (penetration testing) — процесса моделирования атак для проверки стойкости системы к реальным угрозам. Например, Burp Suite или инструменты Kali Linux часто используют как часть проверок веб-приложений. Однако важно понимать, что пентест — это более широкий процесс, а динамический анализ — его важная составляющая, сфокусированная именно на поведении системы при взаимодействии с ней.

Анализ используемых библиотек и зависимостей: контроль цепочки поставки ПО

В современных программных продуктах используется множество сторонних библиотек, фреймворков и зависимостей, которые ускоряют разработку, упрощают реализацию типовых задач и позволяют сосредоточиться на бизнес-логике. Однако каждая такая зависимость — это потенциальная точка риска, особенно если она не обновляется, не проходит проверку на безопасность или берется из непроверенных источников. Именно поэтому контроль используемых компонентов и среды выполнения становится важнейшей частью стратегии обеспечения безопасности ПО.

Анализ библиотек на наличие известных уязвимостей (vulnerability scanning of dependencies) позволяет автоматически определить, содержит ли проект устаревшие или скомпрометированные модули. Большинство таких уязвимостей документированы в общедоступных базах, таких как CVE (Common Vulnerabilities and Exposures), NVD (National Vulnerability Database), GitHub Advisory Database и других. Проблема особенно актуальна для open source-библиотек, которые широко используются, но не всегда оперативно обновляются и поддерживаются.

Вебинар wiSLA 26.02.2026:

Как закрыть потребности в ИТ-мониторинге «под ключ» в 2026 году?

Зарегистрироваться

Что входит в процесс анализа?

-

Проверка версий библиотек и зависимостей: сравнение с последними стабильными версиями;

-

Сканирование на наличие известных уязвимостей по CVE;

-

Оценка степени риска и уровня критичности (severity) для каждой найденной уязвимости;

-

Оповещение команды о необходимости обновлений или возможных мерах по ограничению воздействия уязвимых компонентов;

-

Анализ транзитивных зависимостей: не только тех, что прописаны напрямую в проекте, но и тех, что подтягиваются косвенно через другие пакеты.

Инструменты анализа зависимостей:

Dependabot — встроенный инструмент в экосистему GitHub. Он автоматически отслеживает изменения в открытых уязвимостях для зависимостей, используемых в проекте, и может создавать pull request’ы с безопасными обновлениями. Поддерживает множество языков: JavaScript (npm, yarn), Python (pip), Ruby (bundler), Go (modules) и др.

OWASP Dependency-Check — популярный open source-инструмент, который проводит локальное сканирование зависимостей, находит CVE и формирует отчеты. Подходит как для CI/CD интеграции, так и для ручного анализа.

Snyk — облачный сервис, предлагающий расширенные функции для сканирования зависимостей, Docker-контейнеров и Kubernetes‑манифестов. Предоставляет рекомендации по обновлению, патчам и мерам защиты.

GitHub Advisory Database — официальная база уязвимостей, с которой работают инструменты GitHub (включая Dependabot), предоставляет детальную информацию о каждом инциденте, уровень риска, сроки публикации и рекомендации по устранению.

npm audit, pip-audit, yarn audit и аналоги — встроенные инструменты для быстрой проверки пакетов в экосистемах Node.js, Python и др. Позволяют оперативно выявить критические уязвимости в рамках проекта.

Почему это критично?

-

Уязвимости в сторонних компонентах могут позволить атакующему выполнить произвольный код, получить доступ к данным, внедрить вредоносные зависимости (supply chain attack) или дестабилизировать работу всего приложения. Компрометация даже одного пакета может затронуть тысячи систем — как это было в случаях с Log4j или event-stream;

-

Без постоянного контроля обновлений проект быстро теряет устойчивость к актуальным угрозам

Использование доверенного заимствованного программного обеспечения и инструментов разработки: фундамент безопасности всей системы.

Фиксация версий программного обеспечения: основа для контроля и отслеживания рисков

Для обеспечения безопасности жизненного цикла ПО важно точно фиксировать версии компонентов, которые прошли контрольные процедуры: тестирование, аудит, проверку на уязвимости. Такая фиксация позволяет отслеживать изменения, обеспечивать воспроизводимость сборок, оперативно реагировать на инциденты и управлять рисками при откатах или обновлениях.

Ключевые практики фиксации версий:

-

Автоматизация: использование систем контроля версий (например, git tag) для маркировки стабильных сборок после прохождения тестов и проверок;

-

Контрольные суммы: генерация уникальных хэшей (SHA-256) для каждого релиза, что позволяет проверить целостность дистрибутивов и исключить подмену;

-

Документирование: автоматическое формирование отчетов о версиях, включающих номер сборки, дату, авторов изменений и результаты проверок безопасности.

Такая дисциплина фиксации повышает прозрачность процессов разработки и снижает вероятность человеческих ошибок при переходах между версиями.

Сопровождение всех изменений ПО инструкцией по безопасному обращению и возврату в предыдущую рабочую версию

Одним из ключевых элементов безопасной разработки является организация контролируемого процесса внесения изменений в программное обеспечение. Любое обновление должно сопровождаться подробной документацией, описывающей его суть, потенциальные риски, инструкции по безопасной эксплуатации и, при необходимости, процедуру возврата к предыдущей стабильной версии.

Такая практика позволяет минимизировать риски при внедрении новых функций, исправлении багов или обновлении зависимостей. Особенно важна она в крупных и распределённых командах, а также в критически важных системах, где даже кратковременные сбои могут повлечь серьезные последствия.

Ключевые компоненты процесса:

Документирование изменений.

Использование инструментов генерации технической документации, таких как MkDocs, Sphinx или Doxygen, позволяет автоматически создавать инструкции, release notes, API-описания и руководства для внутренних и внешних пользователей. Это обеспечивает прозрачность и снижает зависимость от устной передачи знаний.

Резервное копирование.

Перед каждым значимым обновлением должна автоматически создаваться резервная копия системы, базы данных и конфигурационных файлов. Это позволяет оперативно восстановить работоспособность приложения в случае возникновения ошибок после релиза.

Сценарии восстановления (rollback scripts).

Для упрощения процесса отката изменений разрабатываются и регулярно проверяются скрипты, позволяющие в один шаг вернуть систему в предыдущее стабильное состояние. Это особенно важно при использовании CI/CD, где развертывания происходят часто и автоматически.

Стандартизированные процедуры.

Все действия по развертыванию, обновлению и откату должны быть описаны в едином регламенте и доступны участникам команды. Это помогает избежать хаотичных решений в стрессовых ситуациях и гарантирует соблюдение правил безопасности.

Компенсационные меры при использовании потенциально уязвимого стороннего ПО

В идеальном мире все используемые компоненты программного обеспечения — проверенные, регулярно обновляемые и лишены уязвимостей. Однако на практике могут возникнуть ситуации, когда организация вынуждена использовать сторонние библиотеки, фреймворки или сервисы, безопасность которых не может быть гарантирована: отсутствует поддержка, патчи выходят с задержкой, или компонент незаменим по функциональности.

В таких случаях ключевой задачей становится разработка и реализация компенсационных мер, которые минимизируют вероятность эксплуатации уязвимостей и ограничивают потенциальный ущерб. Это особенно актуально при работе с устаревшими или проприетарными модулями, интеграциями с внешними API, а также в проектах с жесткими временными или бюджетными рамками.

Что можно предпринять:

-

Изоляция уязвимых компонентов: запуск в отдельных контейнерах или средах, с минимальными правами и ограниченным доступом к сети и ресурсам;

-

Контроль на уровне межсервисного взаимодействи: использование прокси, фильтров и шифрования, чтобы ограничить влияние уязвимого ПО на другие модули;

-

Мониторинг активности: настройка журналирования, алертов и анализа аномалий поведения для раннего выявления подозрительных действий;

-

Периодическая переоценка риска: даже если компонент считается допустимым сегодня, его статус должен регулярно пересматриваться.

Один из самых эффективных способов защиты уязвимого веб-приложения или API — использование Web Application Firewall (WAF). Это программно-аппаратные или облачные решения, которые анализируют входящий и исходящий HTTP(S)-трафик, блокируют попытки эксплуатации уязвимостей и предоставляют гибкие правила фильтрации.

Российские WAF-решения:

Positive Technologies PT Application Firewall — сертифицированное российское решение, защищающее приложения от широкого спектра угроз, включая SQL-инъекции, XSS и другие атаки из списка OWASP Top 10.

КИБ WAF от «Код Безопасности» — отечественный продукт, обеспечивающий защиту веб-приложений и RESTful API, с поддержкой анализа аномалий и централизованным управлением.

Импортные решения:

Cloudflare WAF — облачный WAF, легко настраивается и обеспечивает базовую защиту веб-приложений от типичных угроз. Подходит для компаний любого размера.

AWS WAF — интегрируется с сервисами AWS, поддерживает создание кастомных правил и использование управляемых списков угроз.

Imperva WAF — корпоративный продукт с расширенными возможностями машинного анализа трафика, поведенческой аналитики и интеграции с SIEM-системами.

Open source решения:

ModSecurity — модуль WAF с открытым исходным кодом, широко применяется с веб-серверами Apache, Nginx и IIS. Поддерживает использование набора правил OWASP CRS и может быть интегрирован в различные среды.

Информирование заказчика о выявленных уязвимостях и способах их устранения

Ответственная практика разработки программного обеспечения предполагает не только выявление и устранение уязвимостей, но и прозрачное информирование заказчика о рисках, обнаруженных в процессе анализа и эксплуатации продукта. Такая коммуникация должна быть своевременной, профессиональной и ориентированной на обеспечение безопасности конечной системы.

Наш опыт: безопасность в платформе IT-мониторинга wiSLA

При разработке и развитии платформы wiSLA мы осознанно внедрили лучшие практики информационной безопасности на всех этапах жизненного цикла продукта — от проектирования архитектуры до выкладки в эксплуатацию. Мы придерживаемся принципов secure-by-design, автоматизируем контроль и регулярно проводим внутренние проверки безопасности, включая анализ кода и стресс-тестирование системы.

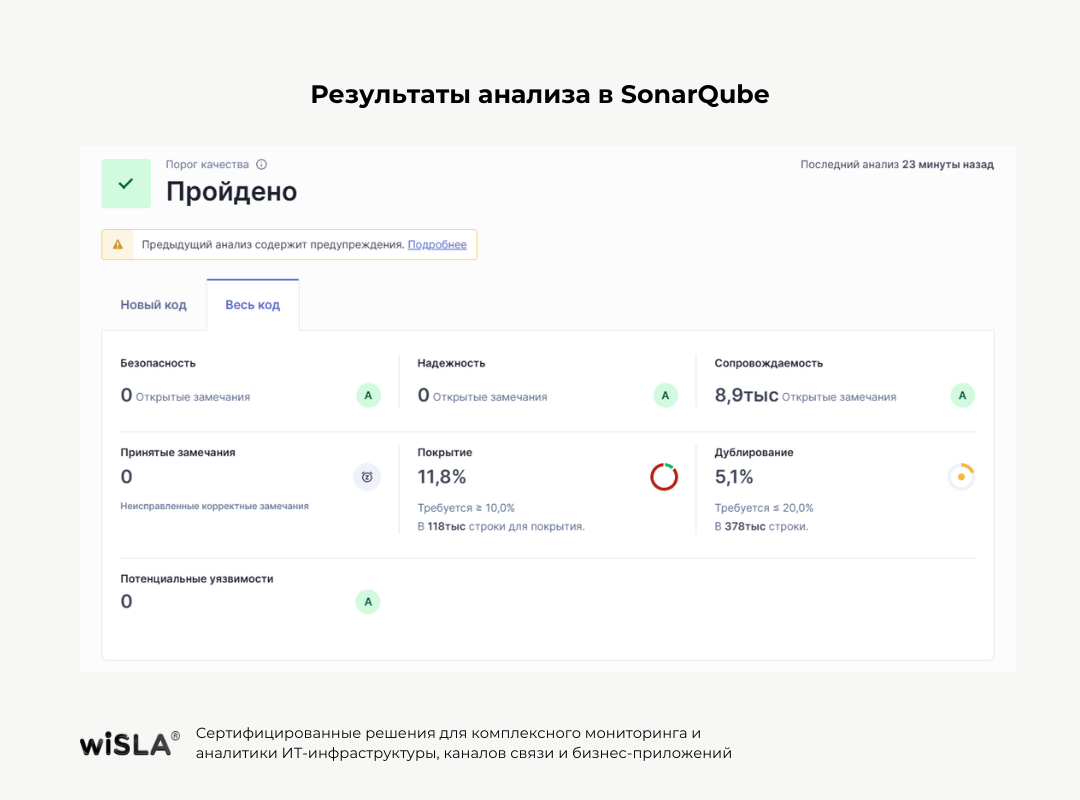

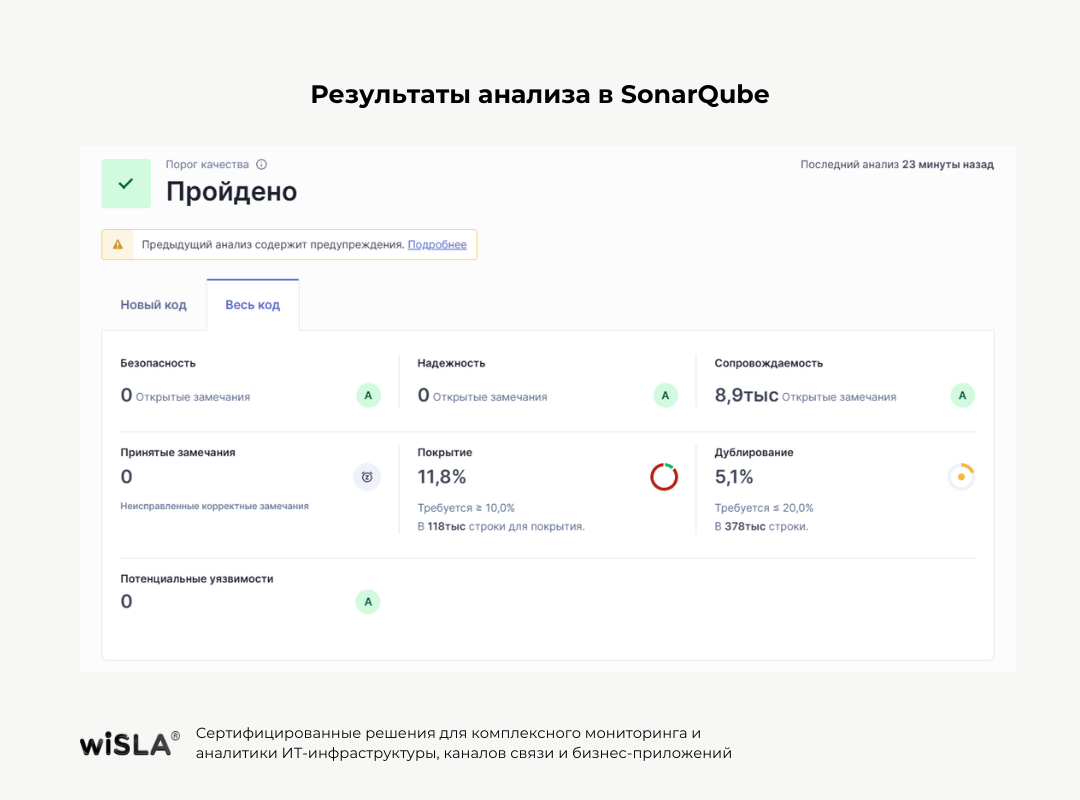

Результаты анализа в SonarQube

Для оценки качества и безопасности кода мы используем платформу SonarQube, которая позволяет выполнять статический анализ с высокой точностью. Последний отчет по полному коду платформы показал следующие ключевые результаты:

Мы регулярно проводим анализ как нового, так и всего кода, тем самым поддерживая стабильный уровень качества и оперативно устраняя возможные отклонения. Такой подход позволяет нам обеспечить устойчивость платформы даже в условиях частых обновлений и масштабирования функциональности.

Фаззинг-тестирование

В дополнение к статическому анализу мы провели фаззинг (fuzz testing) с помощью встроенного фаззера (Fuzzer) в инструменте OWASP ZAP. Фаззинг помогает выявить уязвимости, которые невозможно зафиксировать с помощью анализа кода — например, ошибки при обработке некорректного ввода, нестабильное поведение системы при краевых условиях, утечки памяти и сбои выполнения.

Результаты фаззинг-тестирования подтвердили:

-

отсутствие критических сбоев или уязвимостей при обработке случайных и невалидных данных;

-

стабильную работу сервисов в условиях стресс-нагрузки;

-

надежность логики валидации входных данных и устойчивость к крашам.

Такие проверки проводятся регулярно и дополняются ручным аудитом и ревью, особенно перед выпуском ключевых версий.

wiSLA — это решение, в основе которого лежит зрелый подход к безопасности: прозрачный процесс разработки, автоматизированный контроль, независимая проверка и быстрая реакция на возможные инциденты. Мы уверены, что только такой подход способен обеспечить доверие клиентов и устойчивость в реальной эксплуатации.